Ein neuer Tag, ein neuer Bericht zum Thema Kinderschutz in iOS 15, macOS Monterey und Co. Nach der Veröffentlichung einer ausführlichen FAQ zu dem Thema und einer Gesprächsrunde mit Journalisten hat sich nun auch noch einmal Apples oberster Datenschutz-Manager Erik Neuenschwander zu Wort gemeldet. Im Interview mit den Kollegen von TechCrunch versucht er abermals zu Beschwichtigen und zu versichern, dass der komplette Prozess unter höchstmöglichen Datenschutz-Standards ablaufen wird. Laut Neuenschwander verfügt Apple inzwischen über die Technologien, dass man die CSAM-Scans durchführen könne, ohne dabei den Datenschutz seiner Nutzer zu gefährden.

Ein neuer Tag, ein neuer Bericht zum Thema Kinderschutz in iOS 15, macOS Monterey und Co. Nach der Veröffentlichung einer ausführlichen FAQ zu dem Thema und einer Gesprächsrunde mit Journalisten hat sich nun auch noch einmal Apples oberster Datenschutz-Manager Erik Neuenschwander zu Wort gemeldet. Im Interview mit den Kollegen von TechCrunch versucht er abermals zu Beschwichtigen und zu versichern, dass der komplette Prozess unter höchstmöglichen Datenschutz-Standards ablaufen wird. Laut Neuenschwander verfügt Apple inzwischen über die Technologien, dass man die CSAM-Scans durchführen könne, ohne dabei den Datenschutz seiner Nutzer zu gefährden.

Angesprochen auf die Frage, ob es rückblickend vielleicht keine gute Idee war, die "Communication Safety" Funktion für die Nachrichten-App und die CSAM-Scans in einem Schritt anzukündigen erklärte Neuenschwander, dass die beiden Funktionen, wie auch die ergänzenden Möglichkeiten mit Siri und Spotlight sich durchaus ergänzen. Thematisch hängen sie ohnehin zusammen, weswegen man sich entschieden hat, sie auch gemeinsam anzukündigen.

Die Kollegen stellten dem Datenschutz-Manager auch die unbequeme Frage, ob Apple verschiedenen Regierungen und Behörden auf der Welt demonstrieren wollte, dass man Inhalte nach kriminellen Inhalten durchsuchen kann, ohne dabei den Datenschutz zu gefährden, entgegnete Neuenschwander, dass dies immer ein Ansatz bei Apple sei: Funktion samt Datenschutz. Auf diese Weise könne man illegale Handlungen aufdecken, ohne die Nutzer zu behelligen, die sich nichts zu Schulden haben kommen lassen.

Zudem erklärte der Apple-Manager, dass sich ohnehin nur wenig ändern werde. So blieben die über iMessage verschickten Nachrichten beispielsweise auch weiterhin Ende-zu-Ende verschlüsselt und sämtliche Scanvorgänge fänden ausschließlich auf den Geräten der Nutzer statt. Man habe auch keine Hintertür erstellt, die früher oder später für andere Dinge als das Suchen nach kinderpornografischen Inhalten genutzt werden könnte. Hier habe Apple nach wie vor den Finger drauf und werde andere Nutzungsarten nicht zulassen.

Auf die Frage ob Apple nicht auch dazu gezwungen werden könnte, weitere Dinge außer Kinderpornos über seiner Technologien zu identifizieren, beispielsweise durch Gesetze in Ländern außerhalb der USA, verwies Neuenschwander auf verschiedene Sicherheitsstufen, die Apple auf den Geräten implementiert hat. Unter anderem sei die Liste mit den Hashwerten, gegen die die Bilder abgeglichen werden direkt in das Betriebssystem integriert. Hier mache man keine Unterschiede in unterschiedlichen Ländern und die Liste ist in allen Ländern dieselbe. Zudem gibt es einen Schwellwert an Übereinstimmungen aus der Gesamtheit der Fotos eines Nutzers, der erreicht sein muss, ehe das System überhaupt anschlägt. Einzelne Fotos würden somit niemals auffällig werden. Drittens würde vor einer Meldung an die Behörden auch immer noch ein manuelles Review durchgeführt. Auch hier hat Apple die Hoheit und würde keine anderen erkannten Bilder als solche mit kinderpornografischen Inhalten melden. Last but not least bliebe dem Nutzer auch immer noch die Wahl, iCloud Fotos zu deaktivieren. In diesem Fall würden Apples Maßnahmen nicht anlaufen.

"Kinderporno-Scans: Apples Datenschutz-Manager steht Rede und Antwort" vollständig lesen

Gestern Abend hatte Apple bereits die jeweils fünften Vorabversionen von iOS/iPadOS 15 und tvOS 15 veröffentlicht. Gefehlt haben dabei ganz offensichtlich die zugehörigen neuen Betas von macOS Monterey und watchOS 8. Dieses Versäumnis hat Apple am heutigen späten Abend ausgemerzt und nun auch die jeweils fünften Vorabversionen dieser beiden Betriebssysteme für registrierte Entwickler veröffentlicht. Wie auch bei iOS/iPadOS und tvOS gilt natürlich auch bei macOS Monterey und watchOS 8, dass die finalen Versionen für alle Besitzer eines unterstützten Geräts im Herbst veröffentlicht werden.

Gestern Abend hatte Apple bereits die jeweils fünften Vorabversionen von iOS/iPadOS 15 und tvOS 15 veröffentlicht. Gefehlt haben dabei ganz offensichtlich die zugehörigen neuen Betas von macOS Monterey und watchOS 8. Dieses Versäumnis hat Apple am heutigen späten Abend ausgemerzt und nun auch die jeweils fünften Vorabversionen dieser beiden Betriebssysteme für registrierte Entwickler veröffentlicht. Wie auch bei iOS/iPadOS und tvOS gilt natürlich auch bei macOS Monterey und watchOS 8, dass die finalen Versionen für alle Besitzer eines unterstützten Geräts im Herbst veröffentlicht werden. Ein wenig überraschend hat Apple vor wenigen Minuten ein Update vor macOS Big Sur veröffentlicht, welches ab sofort von allen Besitzern eines unterstützten Macs geladen und installiert werden kann. macOS Big Sur 11.5.2 enthält bislang unbekannte Sicherheitsverbesserungen, die eventuell noch einmal im Zusammenhang mit der Pegasus-Software stehen, über die in den vergangenen Wochen mehrfach berichtet wurde und zu der Apple auch vor knapp zwei Wochen bereits macOS Big Sur 11.5.1 veröffentlicht hatte. Speziell bei derlei Sicherheits-Updates ist allen Nutzern eine Installation natürlich wärmstens ans Herz gelegt. Die Aktualisierung kann wie gewohnt über den Bereich "Softwareupdate" in den Systemeinstellungen geladen werden.

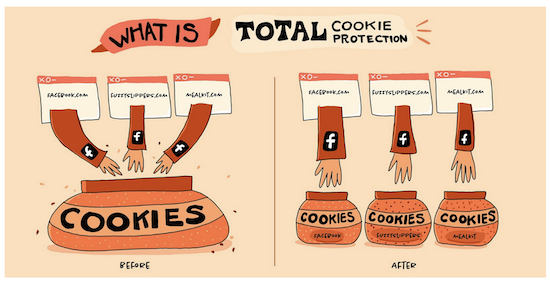

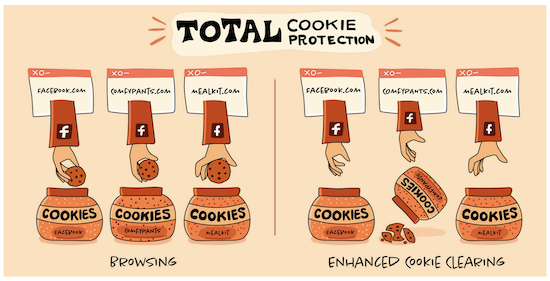

Ein wenig überraschend hat Apple vor wenigen Minuten ein Update vor macOS Big Sur veröffentlicht, welches ab sofort von allen Besitzern eines unterstützten Macs geladen und installiert werden kann. macOS Big Sur 11.5.2 enthält bislang unbekannte Sicherheitsverbesserungen, die eventuell noch einmal im Zusammenhang mit der Pegasus-Software stehen, über die in den vergangenen Wochen mehrfach berichtet wurde und zu der Apple auch vor knapp zwei Wochen bereits macOS Big Sur 11.5.1 veröffentlicht hatte. Speziell bei derlei Sicherheits-Updates ist allen Nutzern eine Installation natürlich wärmstens ans Herz gelegt. Die Aktualisierung kann wie gewohnt über den Bereich "Softwareupdate" in den Systemeinstellungen geladen werden. Ich gebe es zu, die neuen Funktionen von Safari animieren mich eher dazu, bei meinem geliebten Firefox zu bleiben als zu Apples hauseigenem Browser zu wechseln. Man mag mich als "Old-School" bezeichnen aber ich mag den Browser, die Bedienung und die Synchronisation. Das können andere Browser auch und sind dabei vielleicht sogar schneller und ressourcenschonender aber ich bin eben ein Gewohnheitstier. Seit heute steht nun

Ich gebe es zu, die neuen Funktionen von Safari animieren mich eher dazu, bei meinem geliebten Firefox zu bleiben als zu Apples hauseigenem Browser zu wechseln. Man mag mich als "Old-School" bezeichnen aber ich mag den Browser, die Bedienung und die Synchronisation. Das können andere Browser auch und sind dabei vielleicht sogar schneller und ressourcenschonender aber ich bin eben ein Gewohnheitstier. Seit heute steht nun

Die Zubehörprodukte von Pitaka sind inzwischen bekanntermaßen meine bevorzugte Wahl in Sachen iPhone-Hülle und Ladeprodukte. Die Hüllen schmiegen sich nicht nur perfekt an das iPhone an, sondern sind auch extrem stabil unf dank eingearbeiteter Metallfäden auch mit den magnetischen Halterungen des Herstellers ohne weiteres Zubehör kompatibel. Auch für weitere Apple-Produkte wie das iPad Pro hat der Hersteller Zubehör im Programm. Die Ende vergangenen Jahres erstmals vorgestellte Aramidfaserhülle für dieses Gerät liegt nun in einer

Die Zubehörprodukte von Pitaka sind inzwischen bekanntermaßen meine bevorzugte Wahl in Sachen iPhone-Hülle und Ladeprodukte. Die Hüllen schmiegen sich nicht nur perfekt an das iPhone an, sondern sind auch extrem stabil unf dank eingearbeiteter Metallfäden auch mit den magnetischen Halterungen des Herstellers ohne weiteres Zubehör kompatibel. Auch für weitere Apple-Produkte wie das iPad Pro hat der Hersteller Zubehör im Programm. Die Ende vergangenen Jahres erstmals vorgestellte Aramidfaserhülle für dieses Gerät liegt nun in einer  Auch heute hat Apple wieder den sogenannten "Movie Mittwoch" ausgerufen. Dabei wird jeden Mittwoch ein ausgewählter Film aus dem iTunes-Sortiment für 24 Stunden zum Sonderpreis von nur € 1,99 in HD-Qualität zum Leihen angeboten. In dieser Woche handelt es sich dabei um den Liebesfilm

Auch heute hat Apple wieder den sogenannten "Movie Mittwoch" ausgerufen. Dabei wird jeden Mittwoch ein ausgewählter Film aus dem iTunes-Sortiment für 24 Stunden zum Sonderpreis von nur € 1,99 in HD-Qualität zum Leihen angeboten. In dieser Woche handelt es sich dabei um den Liebesfilm

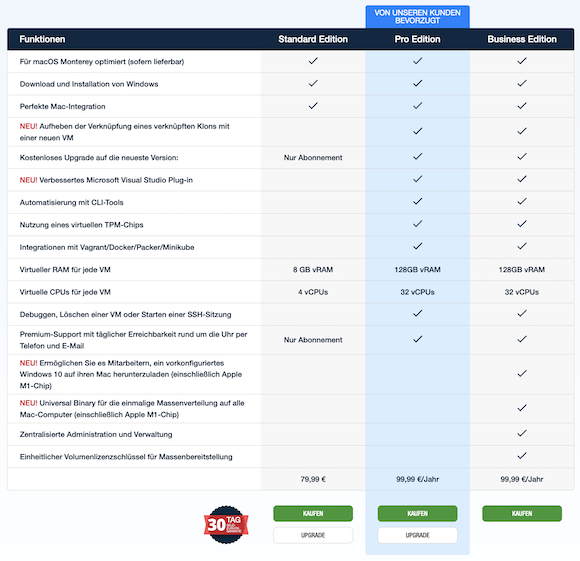

Wenn es um das Thema Virtualisierung auf dem Mac geht, ist

Wenn es um das Thema Virtualisierung auf dem Mac geht, ist

Ein neuer Tag, ein neuer Bericht zum Thema Kinderschutz in iOS 15, macOS Monterey und Co. Nach der Veröffentlichung einer ausführlichen FAQ zu dem Thema und einer Gesprächsrunde mit Journalisten hat sich nun auch noch einmal Apples oberster Datenschutz-Manager Erik Neuenschwander zu Wort gemeldet. Im Interview mit den Kollegen von

Ein neuer Tag, ein neuer Bericht zum Thema Kinderschutz in iOS 15, macOS Monterey und Co. Nach der Veröffentlichung einer ausführlichen FAQ zu dem Thema und einer Gesprächsrunde mit Journalisten hat sich nun auch noch einmal Apples oberster Datenschutz-Manager Erik Neuenschwander zu Wort gemeldet. Im Interview mit den Kollegen von  Die Fertigungstechnologien von Prozessoren und weiteren Chips werden immer ausgefeilter, was zu immer energiesparender und gleichzeitig leistungsfähigerer Hardware führt. Dies gilt zunehmend auch für die von Apples Fertigungspartner TSMC gefertigten Chips, was auch einer der Gründe dafür war, warum sich Apple von seinem bisherigen Prozessorlieferanten Intel trennte und künftig auf selbstdesignte Prozessoren für den Mac setzt. Während die aktuell eingesetzten Chips noch im 5nm Verfahren gefertigt werden, könnten bereits ab 2022 iPhones und Macs mit Prozessoren bestpckt sein, die im 3nm Verfahren gefertigt wurden. Die Massenproduktion dieser Chips soll bei TSMC in der zeiten Hälfte des kommenden Jahres beginnen. Damit wäre der nächste Meilenstein nur zwei Jahre nachdem man den 5nm Prozess einführte erreicht. (via

Die Fertigungstechnologien von Prozessoren und weiteren Chips werden immer ausgefeilter, was zu immer energiesparender und gleichzeitig leistungsfähigerer Hardware führt. Dies gilt zunehmend auch für die von Apples Fertigungspartner TSMC gefertigten Chips, was auch einer der Gründe dafür war, warum sich Apple von seinem bisherigen Prozessorlieferanten Intel trennte und künftig auf selbstdesignte Prozessoren für den Mac setzt. Während die aktuell eingesetzten Chips noch im 5nm Verfahren gefertigt werden, könnten bereits ab 2022 iPhones und Macs mit Prozessoren bestpckt sein, die im 3nm Verfahren gefertigt wurden. Die Massenproduktion dieser Chips soll bei TSMC in der zeiten Hälfte des kommenden Jahres beginnen. Damit wäre der nächste Meilenstein nur zwei Jahre nachdem man den 5nm Prozess einführte erreicht. (via